前言

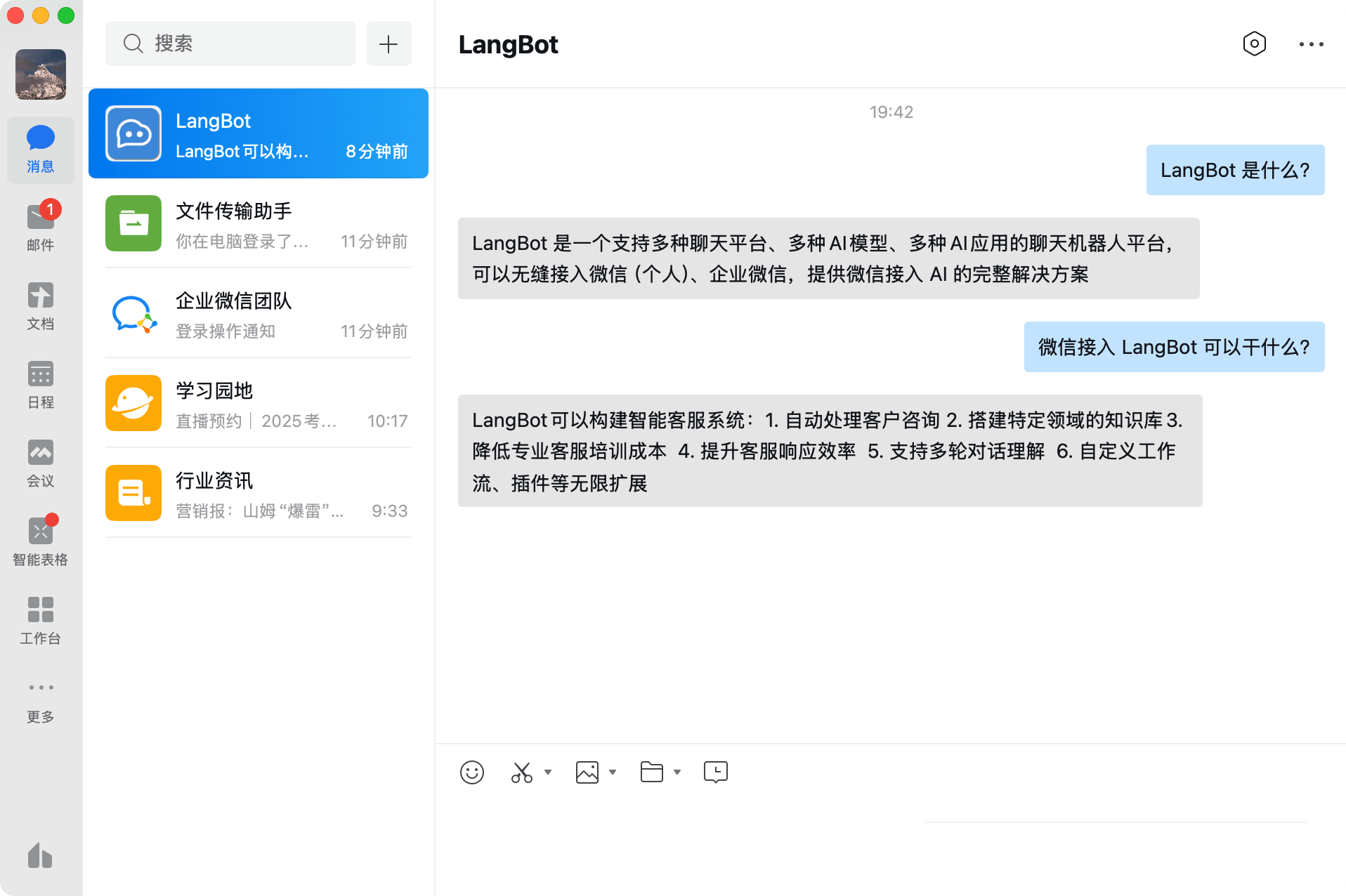

LangBot 是一款开源的大语言模型即时通信机器人平台,旨在将 AI 助手无缝集成至 QQ、微信、飞书等主流聊天工具中。无论是个人用户还是企业团队,都能通过 LangBot 快速搭建属于自己的 AI 助手。

说实话,当我在GitHub上看到LangBot这个项目时,心里想这不就是一个聊天机器人吗?但12.3k的星标数让我停下了鼠标。点进去看了看,才发现这玩意儿真的不一样。

RockChinQ这个开发者,我觉得他真的懂用户想要什么。你想想,现在谁还想为了用个AI助手专门下载一个又一个app?我们已经习惯了QQ、微信、飞书这些平台,如果AI能直接出现在这里,而且还可以自由定制…

确实,LangBot就是这么做的。

项目最开始叫QChatGPT,现在改名LangBot。这个变化本身就说明——从专注ChatGPT到支持几乎所有主流大模型。这种变化是正确的选择,这也正反映了实际的需求:用户需要选择的自由。

功能概述

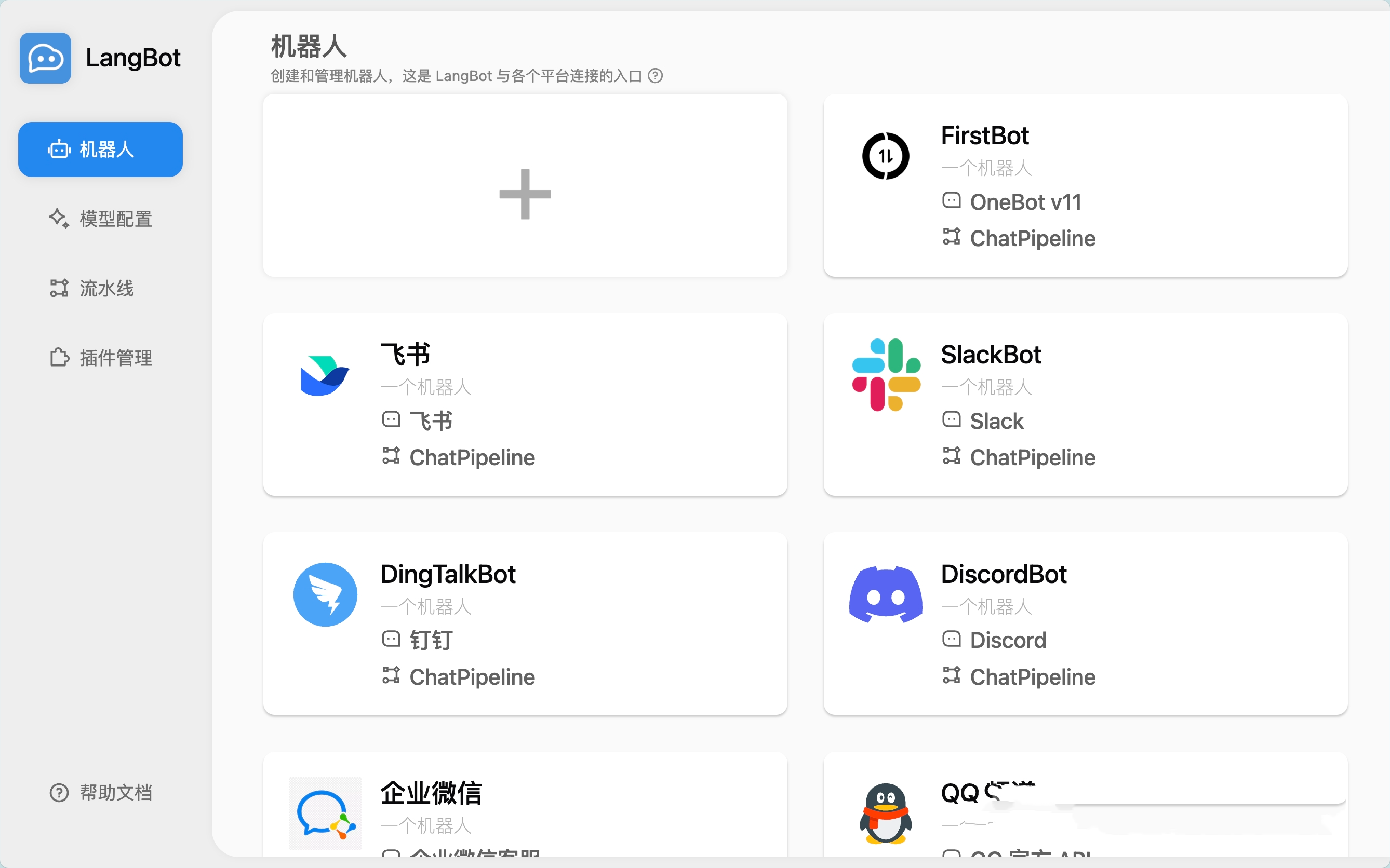

LangBot支持QQ、微信(企业版和个人版都行)、Discord、Telegram、飞书、钉钉、Slack…基本上你能想到的聊天软件它都能接入。

这种感觉怎么说呢?就像你养了一只特别聪明的宠物,它知道在什么场合该怎么表现。

模型支持丰富

ChatGPT、DeepSeek、Claude、Gemini、Ollama…我数了数,支持的模型有二十多种。Claude那种优雅的回答风格,DeepSeek的深度思考,ChatGPT的幽默感…你想要哪种都能找到。

有时候我会想,如果AI有性格,那LangBot就是一个性格多面的朋友。今天想要严肃点的对话?换个模型。想要轻松点的?再换一个。

多模态交互

现在文本对话已经太基础了,但LangBot还能处理语音、图片。你发个图片给它,它能看懂并且给出相关的回答。这种体验让人觉得,AI不再是那个只会处理文字的冰冷程序。

Web管理面板这个功能…我得承认,这个设计真的很贴心。不用再对着一堆配置文件发愁了,点点鼠标就能搞定一切。

🚀 项目亮点

- 多平台适配:支持 QQ、企业微信、个人微信、飞书、Discord、Slack、钉钉、Telegram 等多个主流即时通讯平台。

- 多模型支持:兼容 ChatGPT、Claude、DeepSeek、Gemini、Ollama、Dify 等 20 多种大语言模型,满足不同场景需求。

- 多模态交互:支持文本、语音、图片等多种输入输出形式,实现更丰富的用户体验。

- 插件扩展:内置数百个插件,支持事件驱动和组件扩展,满足个性化需求。

- Web 管理面板:提供直观的浏览器管理界面,简化配置和管理流程。

消息平台

| 平台 | 状态 | 备注 |

| QQ 个人号 | ✅ | QQ 个人号私聊、群聊 |

| QQ 官方机器人 | ✅ | QQ 官方机器人,支持频道、私聊、群聊 |

| 企业微信 | ✅ | |

| 企微对外客服 | ✅ | |

| 个人微信 | ✅ | |

| 微信公众号 | ✅ | |

| 飞书 | ✅ | |

| 钉钉 | ✅ | |

| Discord | ✅ | |

| Telegram | ✅ | |

| Slack | ✅ |

大模型能力

| 模型 | 状态 | 备注 |

| OpenAI | ✅ | 可接入任何 OpenAI 接口格式模型 |

| DeepSeek | ✅ | |

| Moonshot | ✅ | |

| Anthropic | ✅ | |

| xAI | ✅ | |

| 智谱AI | ✅ | |

| 胜算云 | ✅ | 全球大模型都可调用(友情推荐) |

| 优云智算 | ✅ | 大模型和 GPU 资源平台 |

| PPIO | ✅ | 大模型和 GPU 资源平台 |

| 302.AI | ✅ | 大模型聚合平台 |

| Google Gemini | ✅ | |

| Dify | ✅ | LLMOps 平台 |

| Ollama | ✅ | 本地大模型运行平台 |

| LMStudio | ✅ | 本地大模型运行平台 |

| GiteeAI | ✅ | 大模型接口聚合平台 |

| SiliconFlow | ✅ | 大模型聚合平台 |

| 阿里云百炼 | ✅ | 大模型聚合平台, LLMOps 平台 |

| 火山方舟 | ✅ | 大模型聚合平台, LLMOps 平台 |

| ModelScope | ✅ | 大模型聚合平台 |

| MCP | ✅ | 支持通过 MCP 协议获取工具 |

🛠 技术栈

- 编程语言:Python 3.10 以上

- 部署方式:Docker、宝塔面板、Zeabur、Railway 等多种方式

- 协议支持:支持 Anthropic MCP 协议,适配多种大语言模型

- 功能模块:Agent、RAG(知识库)、MCP 等多种 LLM 应用功能

⚙️ 部署方式

LangBot 提供多种部署方式,用户可以根据自己的需求选择合适的方式。

Docker 部署

- 克隆仓库:

git clone https://github.com/langbot-app/LangBot- 进入目录:

cd LangBot- 启动服务:

docker compose up -d- 访问管理界面:

打开浏览器,访问 http://localhost:5300 即可开始使用。

宝塔面板部署

如果您已安装宝塔面板,可以根据官方文档进行部署。

云部署

支持 Zeabur、Railway 等云平台部署,具体可参考官方文档。

上手体验

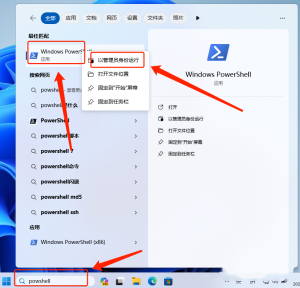

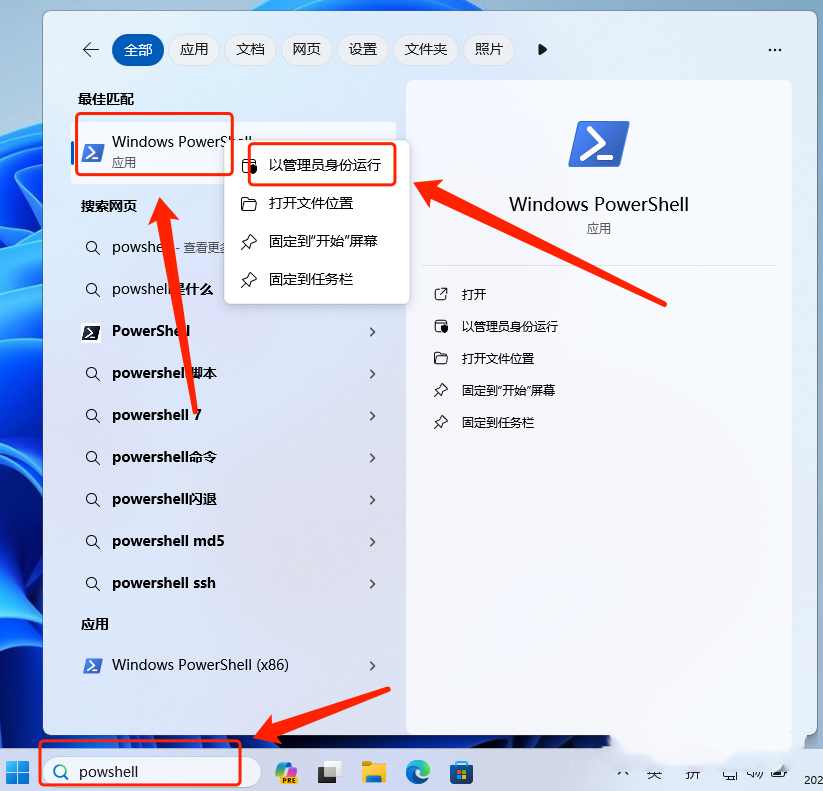

环境要求不算苛刻,Python 3.10.1以上就行,推荐3.10.14。

Docker部署真的简单:

git clone https://github.com/RockChinQ/LangBot

cd LangBot

docker compose up -d三行命令,然后访问 http://localhost:5300,就能看到管理界面了。我第一次试的时候,心里想的是”就这么简单?”

🧪 使用方式

1.添加机器人

- 在对应的聊天平台添加 LangBot 机器人为好友或加入群聊。

2. 开始对话

- 发送消息开始与机器人对话。

3. 使用命令

- 发送

!help查看帮助信息。 - 发送

!draw <图片描述>获取生成的图片。 - 发送

!list查看历史会话。

4. 管理设置

- 通过 Web 管理面板进行配置和管理。

LangBot 的活跃社区和丰富的插件生态,使其成为构建 AI 助手的理想选择。无论是个人用户还是企业团队,都能通过 LangBot 快速搭建属于自己的 AI 助手。

用过之后的一些想法

和其他机器人平台比起来,LangBot的优势很明显。传统平台大多绑定单一AI服务,你想换个模型?不好意思,不支持。LangBot不一样,它给你选择的自由。

商业化的解决方案通常意味着月付费、年付费,还要担心数据安全。LangBot完全开源,你想怎么改就怎么改,数据都在自己手里。

如果你想从零开始搭建一个聊天机器人…相信我,那会很痛苦。各种API接入、安全机制、错误处理…LangBot把这些都做好了,你只需要专注于使用。

v4.0.7版本,27个贡献者。这个数字背后是一个活跃的开源社区,意味着这个项目不会因为某一个人的离开而停止更新。

插件系统也很强大,目前已经有数百个插件可以选择。

项目地址

地址1:https://github.com/langbot-app/LangBot

地址2:https://github.com/RockChinQ/LangBot

写在最后

LangBot不是完美的,但它解决了一个真实的痛点:让AI助手融入我们已有的交流习惯。我们不需要为了用AI而改变使用习惯,AI应该适应我们。

开源的魅力就在于此。一群有想法的开发者聚在一起,做出一个真正有用的东西,然后分享给所有人。这种精神在现在这个时代,显得格外珍贵。

如果你也在寻找一个好用的AI聊天机器人解决方案,LangBot值得一试。不是因为它完美,而是因为它真诚。

![图片[1]-13.2k Stars!这个开源神器让你的聊天软件瞬间智能化:QQ/微信秒变 AI 助手](http://img.seekresource.com/img/12237)

![图片[2]-13.2k Stars!这个开源神器让你的聊天软件瞬间智能化:QQ/微信秒变 AI 助手](http://img.seekresource.com/img/12238)

![图片[3]-13.2k Stars!这个开源神器让你的聊天软件瞬间智能化:QQ/微信秒变 AI 助手](http://img.seekresource.com/img/12239)

![图片[4]-13.2k Stars!这个开源神器让你的聊天软件瞬间智能化:QQ/微信秒变 AI 助手](http://img.seekresource.com/img/12240)

![图片[5]-13.2k Stars!这个开源神器让你的聊天软件瞬间智能化:QQ/微信秒变 AI 助手](http://img.seekresource.com/img/12241)

![表情[chi]-寻找资源网](http://www.seekresource.com/wp-content/themes/zibll/img/smilies/chi.gif)

暂无评论内容